Internet regorge d’un nombre incalculable d’informations. Afin de vous aider à trouver celle que vous recherchez réellement, Google a mis en place un système de classement afin de trier les pages web pour vous proposer les résultats les plus pertinents, c’est-à-dire les résultats qui, selon lui, répondent le mieux à votre requête. Ce système de classement fonctionne sur la base d’algorithmes qui s’appuient sur de multiples critères tels que les mots qui composent votre requête, la pertinence des réponses possibles (lisibilité des pages web de résultats, professionnalisme de la source, version mobile adaptée…) ou encore votre position géographique.

Ce qu’il faut savoir des algorithmes de Google

À proprement parler, les algorithmes de Google sont donc un ensemble de calculs analysant de nombreux critères dans le but de déterminer la valeur SEO d’un site, c’est-à-dire la place de celui-ci dans les résultats de recherche en fonction de la requête.

Pour votre référencement naturel et afin d’être visible si un internaute vous recherche, il est donc primordial d’avoir une idée des différentes règles qu’imposent ces différents algorithmes. Vous pourrez ainsi avoir une longueur d’avance sur vos concurrents en augmentant votre visibilité en ligne et en gagnant des places dans les résultats de recherche Google.

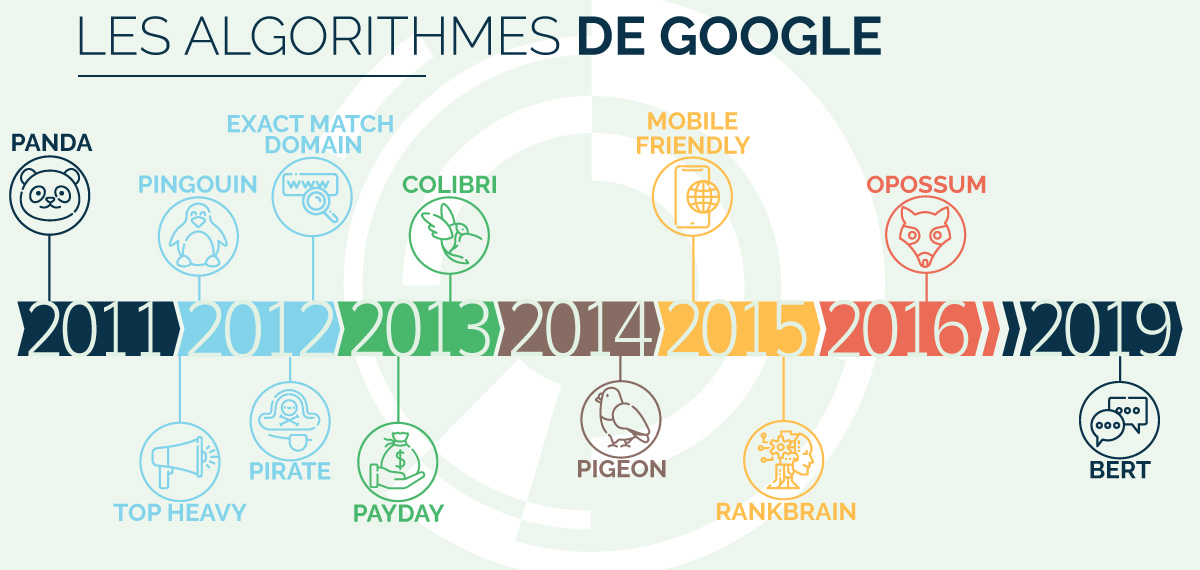

Sachez tout d’abord qu’il existe une multitude d’algorithmes. Voici une liste chronologique des principaux algorithmes qui ont le plus impacté le référencement Google depuis les 15 dernières années…

Les algorithmes Google impactant le SEO

Panda

Paru pour la première fois en février 2011, Panda est un “filtre de recherche”. Il s’intéresse aux contenus des sites internet afin de pénaliser le référencement de ceux qui présentent un contenu de faible qualité. Le but est de débarrasser le moteur de recherche des sites de contenus créés uniquement pour le référencement et le spam. Cet algorithme a connu de nombreuses mises à jour depuis la parution de sa première version, incluant notamment de nouveaux critères et des modifications des délais entre chaque analyse.

Top Heavy – Excès de publicité

Déployé en janvier 2012, il pénalise les sites internet contenant un nombre trop important de publicités, surtout si celles-ci figurent au-dessus de la ligne de flottaison, c’est-à-dire la partie directement visible au chargement de la page. Bien qu’il soit important de connaître son existence, contrairement à ce que l’on pourrait penser, son impact reste relativement faible sur les résultats de recherche.

Pingouin

L’algorithme Pingouin et ses mises à jour sont redoutés par les webmasters et autres chargés de référencement. Sa première version, mise en place en avril 2012, vise à pénaliser les sites de « mauvaise qualité ». Cet algorithme vient donc en supplément de Panda, en ajoutant de nouveaux critères de pénalisation, comme les pratiques abusives de netlinking ou l’utilisation de liens frauduleux.

À sa création, Pingouin évaluait les sites à chacune de ses mises à jour. Aujourd’hui et depuis 2016, il fonctionne en temps réel et pousse désormais tout détenteur d’un site web à rester constamment vigilant quant aux liens qu’il fait apparaître sur son site.

Pirate

Filtre de recherche mis en place en août 2012, Google Pirate est un algorithme qui vise à protéger la violation directe de la loi Digital Millennium Copyright Act (DMCA). Cette loi américaine a pour but de lutter contre les violations de droit d’auteur en établissant une propriété intellectuelle.

Google Pirate détecte et pénalise les sites web violant le protocole de droits d’auteur en réduisant ou retirant totalement leur classement dans les résultats de recherches, sans préavis. Ainsi, cet algorithme protège également l’auteur d’origine du contenu. Il est mis à jour régulièrement afin de retirer des résultats les sites proposant des pratiques de téléchargement illégales de musiques, de films ou encore de séries.

Exact Match Domain (EMD) – Correspondance exacte au nom de domaine

Bien que le nom de domaine ait une grande influence sur le référencement, il n’est pas forcément gage de qualité, et ça, Google l’a compris. Cet algorithme paru en septembre 2012 permet d’analyser les sites dans le but de ne pas référencer dans les premiers résultats des sites de faible qualité sous prétexte que la requête correspond au nom de domaine. Il n’est désormais plus possible de proposer des noms de domaines optimisés en espérant un meilleur référencement organique si le contenu du site ne suit pas.

Payday

Mis en place en juin 2013, l’algorithme Payday, aussi appelé Payday Loan, vise à pénaliser le classement des sites qui sont suspectés d’utiliser des techniques de spams. Depuis sa mise en place, Payday a permis de sanctionner des centaines de milliers de résultats tels que des sites de crédits, de contrefaçon, ou encore des sites de jeux en ligne.

Hummingbird ou Colibri

Considéré comme l’un des plus importants, l’algorithme Hummingbird est paru en septembre 2013 dans le but de mieux prendre en considération chaque mot d’une requête afin de préciser les résultats. Il répond à une volonté de mieux comprendre les intentions des internautes lors de leur recherche.

Auparavant, Google traitait chaque mot d’une requête indépendamment et fonctionnait sur l’usage de mots clés. Désormais, grâce à cet algorithme, la compréhension d’une requête est plus poussée, et Google peut désormais comprendre le sens d’une phrase dans sa globalité en se basant sur la sémantique.

Pigeon

Cette mise à jour de l’algorithme de Google déployée en décembre 2014 impact le référencement local. Elle permet principalement d’améliorer les paramètres de classement liés à la localisation et de rapprocher les critères de remontée de résultats entre les recherches sur Google Maps et les recherches classiques. Cela signifie que, depuis l’algorithme Pigeon, les résultats des recherches Google Maps sont influencés par un grand nombre de critères comme la pertinence, l’orthographe, le netlinking, la qualité du contenu et d’autres centaines de critères. Voilà une bonne raison de soigner attentivement son référencement web local.

Mobile friendly

On dit d’un site internet qu’il est mobile friendly lorsqu’il prend en compte le support utilisé par l’internaute pour le visiter et qu’il adapte les contenus pour améliorer l’ergonomie et la lisibilité.

Mis en place en avril 2015, cet algorithme de référencement met en avant les sites internet responsive, c’est-à-dire qui s’adaptent à l’affichage sur différents appareils. En plus d’être utile pour satisfaire vos internautes détenteurs d’un smartphone ou d’une tablette, il est primordial d’être vigilant dans la conception de son site pour que celui-ci soit adapté aux mobiles afin de ne pas être pénalisé dans les résultats de recherche Google.

Rankbrain

Basé sur l’intelligence artificielle, cet algorithme confirmé par Google en octobre 2015 à pour but de traiter et analyser les requêtes complexes afin de fournir aux internautes des résultats toujours plus pertinents. Celui-ci repose sur le « Machine Learning » et est donc en constant apprentissage automatique. Utile pour le développement de la recherche vocale, cette mise à jour ne fait que préciser les règles de Google. Le seul moyen d’en tirer profit est donc de respecter les bonnes pratiques pour optimiser son SEO.

Opossum 2016

En septembre 2016, Google continue de travailler sur sa volonté de rendre chaque réponse à chaque requête le plus pertinent possible et annonce l’arrivée de l’algorithme Opossum. Son rôle est d’agir pour une meilleure prise en compte des recherches géographiques réalisées par les internautes. Parmi les impacts connus, on retrouve un élargissement géographique des résultats de recherche, un triage en fonction des adresses postales et enfin une impossibilité d’afficher des résultats en doublons à la fois dans les recherches locales et dans les recherches organiques.

BERT 2019

Toujours tourné vers l’optimisation de la recherche vocale, Google a annoncé l’algorithme BERT en octobre 2019. Elle compte parmi les plus grandes mises à jour de Google car elle affecterait environ 10% des requêtes. Basée sur une technique de traitement du langage, elle vise à offrir une meilleure interprétation des intentions des requêtes. Au lieu d’analyser la requête mot après mot, cet algorithme permet à Google d’analyser une expression entière. Cela engendre donc une meilleure compréhension de l’intention de l’internaute, même avec des requêtes complexes.

Cette liste non exhaustive renseigne les mises à jour importantes des algorithmes de Google. En réalité, il existe un plus grand nombre d’algorithmes aux impacts mineurs ou ayant seulement pour but d’améliorer des algorithmes préexistants.

Maintenant que vous comprenez un peu mieux le fonctionnement de Google et de ses algorithmes, vous avez toutes les clés en mains pour optimiser votre SEO.